AI 和 LLM 的快速发展将挑战 AI 基础设施对 GPU 和 DRAM 的依赖,从而产生新的架构方法,以更好地利用高容量 NAND 闪存。

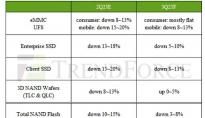

群联电子股份有限公司公布了对 2024 年 NAND 闪存基础设施部署趋势的预测。

它预测,随着采用率的迅速扩大,基于 PCIe 5.0 的基础设施将为 AI 工作负载一致性提供高性能、可持续的支持,从而继续快速扩散。PCIe 5.0 NAND闪存解决方案将成为均衡硬件生态系统的核心,本地大型语言模型(LLM)等私有AI部署将推动日常AI及其所需基础设施的显著增长。

“我们正在从最初对人工智能的兴奋转向更广泛的日常技术部署。在这些配置中,高质量的 AI 输出必须通过设计安全且经济实惠的基础设施来实现。利用人工智能提高生产力的组织将取得令人难以置信的成功,“群联美国首席技术官 Sebastien Jean 说。“基于人工智能应用的广泛扩散,基础设施提供商将负责确保人工智能模型不会遇到内存限制,而NAND闪存将成为我们如何配置数据中心架构以支持当今不断发展的人工智能市场的核心,同时为我们快速发展的数字未来的成功奠定基础。

2023 年的方向很明确:人工智能将继续渗透到我们的生活中,未来一年数字基础设施的主要目的是在生产环境中支持这些关键模型。随着人工智能日益普及,数据中心架构师将面临挑战,既要维持大型LLM等应用程序的激增,又要构建能够长期维护和扩展这些操作的系统。

公司的数据科学家和数字基础设施专家认为,未来成功的人工智能实施将对已知和未知的数据威胁保持警惕,同时摆脱对加速器技术的过度依赖,从而实现更平衡的系统。

群联的预测包括:

- SSD、GPU、DRAM 和其他基本数据中心组件将越来越多地包括设备级加密识别、证明和数据加密,以帮助更好地保护数据免受攻击,因为 AI 部署暴露了新的数字威胁。

- 为 LLM 部署私有的本地基础设施,以便在专有数据上运行 AI 模型训练,而不会暴露于与云相关的安全漏洞。

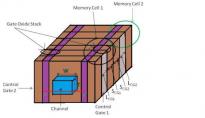

- AI 和 LLM 的快速发展将挑战 AI 基础设施对 GPU 和 DRAM 的依赖,从而产生新的架构方法,以更好地利用高容量 NAND 闪存。

- 在这些系统中,PCIe 5.0 NAND 闪存将获得更广泛的采用,以最快的速度和效率为生产环境中的应用提供动力,从而释放 GPU 和 DRAM 来单独运行 AI 推理模型,从而最大限度地提高资源效率和生产力。

- 私人LLM最初将专注于那些不受严格的上市时间限制的基本活动,例如改善专业人士的聊天机器人交互和专利产品的渐进式进步。

- 随着这些私有部署取得积极成果,应用程序将适应相邻的操作和程序,从而进一步普及这些日常人工智能基础设施解决方案。

群联总部首席技术官、群联人工智能研发负责人兼人工智能学院助理教授林伟博士表示:“通过利用既定和新兴的安全策略并拥抱基础设施硬件设计的进步,2024 年最成功的公司将认识到,强大而平衡的基础设施可以提供战术和战略机会,同时进一步推动人工智能驱动的数据生态系统的创新,随着关键基础设施的发展以支持人工智能的快速发展,NAND闪存解决方案将发挥核心作用,实现与GPU和DRAM的更大架构平衡,以实现平衡系统,以最大限度地发挥持续、长期AI部署的优势。

凭借业界最广泛的 PCIe 5.0 NAND 闪存和信号调理解决方案产品组合之一,该制造商为不断增长的 Gen5 数据生态系统提供了现代企业数据生态系统的整体愿景。该公司的低功耗、高性能 NAND 闪存和信号完整性解决方案和服务经过优化,可为当今的 AI 应用提供平衡、低功耗的工作负载性能,并可扩展以应对未来的所有挑战。

群联的 IMAGIN+ 设计服务使组织能够根据其特定性能需求设计高效的 NAND 闪存架构,其 aiDAPTIV+ 平台正在将大容量 NAND 闪存解决方案集成到 AI 系统的核心中。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。