我们正面临着即将到来的数据洪流,因为我们可能会达到每秒百万次的数据速率,因此在过去的五年里,这让我更多地投入到边缘计算中。

从天气传感器和自动驾驶汽车到电网监控和云游戏,世界边缘计算正变得越来越复杂——但 HPC 世界不一定赶上这些边缘的快速创新。在 Nvidia 的虚拟GTC22(“HPC、AI 和边缘”)的一个小组中,五位专家讨论了领先的 HPC 应用程序如何从更深入地结合人工智能和边缘技术中受益。

小组成员:Tom Gibbs,Nvidia 的开发者关系;Michael Bussmann,高级系统理解中心 (CASUS) 的创始经理;Ryan Coffee,SLAC 国家加速器实验室的高级科学家;Brian Spears,劳伦斯利弗莫尔国家实验室 (LLNL) 惯性约束聚变 (ICF) 能源研究的首席研究员;和 Arvind Ramanathan,阿贡国家实验室计算生物学研究的首席研究员。

洪水的边缘,边缘的洪水

在小组讨论的早期,担任讨论主持人的 Gibbs 将 2020 年代称为“实验的十年”,并解释说几乎每个与 HPC 相邻的领域都处于拥有主要实验仪器(或重大升级到现有仪器)联机。“这真的很令人兴奋;但另一方面,这些将产生大量丰富的数据,”他说。“我们如何才能最有效地使用和管理这些数据来产生新的科学,这确实是关键问题之一。”

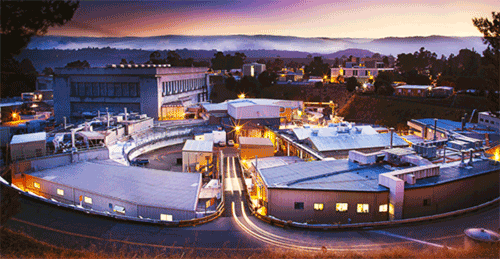

咖啡同意了。“我实际上在 SLAC 的X 射线激光设施中,所以我是从短脉冲时间分辨分子物理学的角度来看的,”他说。“而且我们正面临着即将到来的数据洪流,因为我们可能会达到每秒百万次的数据速率,因此在过去的五年里,这让我更多地投入到边缘计算中。因此,我对此提出的意见是:我们如何将传感器上的智能与云中 HPC 的实际情况整合起来?”

SLAC 国家加速器实验室。图片由斯坦福大学提供。

“我看到的主要机会之一是:我们现在可以看到罕见的事件,”他继续说道。“没有人会真正做到每秒移动 TB 数据——这没有任何意义——但是,我们需要能够每秒记录 TB 数据,以观察真正推动科学发生的异常情况。 。”

来自 LLNL 聚变研究的 Spears 以他所在的领域为例。他指出最近在 LLNL 的 ICF 实验中取得了成功,该团队成功地从聚变反应中产生了 1.35 兆焦耳的能量——几乎收支平衡——而欧洲的 JET 团队在过去几个月中也取得了类似的突破。但他说,聚变研究依赖于“来自我们相机的数据流,用于持续——你知道,一些动作发生在 100 皮秒以上的实验。”

“我们需要每秒记录 TB 数据的能力,以观察真正推动当前科学发展的异常情况。”

锐化 AI 的优势

所以:在非常快的时间尺度上的大量数据,目的是从每天一次的实验转变为每秒多次的实验。斯皮尔斯解释了他们打算如何处理这个问题。“我们要快速做事;我们将在边缘的硬件中完成它们;我们可能会使用可以进行低精度、快速计算的 AI 模型来完成它们,但这将与来自领先机构的非常高精度的模型相关联。”

“你可以从这些应用程序中开始看到实验和时间尺度的融合,”他说,“推动我们思考表示物理和模型并将其移动到边缘的方式发生变化[.]”

然后,人工智能加速了同样的策略,帮助减少从边缘移动到更大设施的数据。“你可以使用人工智能来指导实验必须去哪里,看看我们可能错过了哪些数据,”拉马纳坦说。

Bussmann 表示同意,并列举了许多领域使用“不会永远记录的实时数据流”——“所以我们必须做出快速决策,我们必须做出明智的决策,”他说。“我们意识到这是一个跨领域的总体主题,因为功能已经[广泛]。”

斯皮尔斯说:“人工智能提供了一种能力,可以对其进行包装,训练一个轻量级的代理模型,并将我脑海中的真实想法移动到计算设施的边缘。” “我们现在可以出于两个目的进行实验:一个是优化实际实验本身的情况——这样我们就可以转向更亮的光束或更高温度的等离子体——但我们也可以说,‘我错了关于我的想法,因为作为一个人,我对世界的看法有一些弱点。所以我也可以把我的实验引导到我不太擅长的地方,我可以利用实验来让我的模型变得更好。如果我可以通过在边缘进行计算来收紧这些循环……我可以得到双重结果,让我的实验更好,让我的模型更好。”

“如果我可以通过在边缘进行计算来收紧这些循环……我可以得到双重结果,让我的实验更好,让我的模型更好。”

只是时间问题

小组后半部分的大部分讨论都集中在如何使用这些人工智能和边缘技术有效地插入稀疏或低分辨率数据。“你真的需要这些替代模型,”Ramanathan 解释说,他的药物发现工作如何在 15 到 20 个数量级的范围内运作,并且为了解决这个问题,“建立可以自适应地对这个景观进行采样而不需要所有此信息”:罕见事件识别。

“我可以非常便宜地运行一维模型——我可以运行其中的 5 亿个,也许,”斯皮尔斯说。“二维模型要贵几百或一千倍。三维模型比这贵数千倍。所有这些都有助于我在参数空间中进行探索,因此工作流工具允许我们做的就是在数据中心做出决定:交互式运行所有这些 1D 模拟,让我决定获得多少信息我正在从这些模拟中获得收益。”

“当我认为我找到了一个具有高价值房地产的区域、参数或设计空间时,我会做出一个工作流程决定,说‘种植一些 2D 模拟而不是 1D’,然后我会继续努力高价值房地产的另一个更精确的区域。然后我可以再次提升到只能运行几次的三维模型。这就是我们在劳伦斯利弗莫尔国家实验室拥有的一台像 Sierra 这样的机器上的所有高精度计算。”

Sierra 超级计算机

“我们所有的问题都是对数比例的,对吧?” 加咖啡。“我们想要对多个尺度敏感——不管你在哪个领域。......我们都在使用计算机来帮助我们做我们做得不好的事情,那就是快速吞下数据足够的。”

“当您开始谈论为多个域集成工作流并且它们都具有相似的使用模式时,这难道不是要求我们提供一种基础架构,将 HPC 与边缘绑定在一起以遵循通用模型和跨域的通用基础架构?” 他继续。“我认为我们都在要求相同的基础设施。现在,这个基础设施真的不仅仅是数据中心发生的事情,对吧?这就是数据中心发生的事情,以及它如何几乎在神经学上与广泛分布在我们文化中的所有边缘传感器相连。”

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。