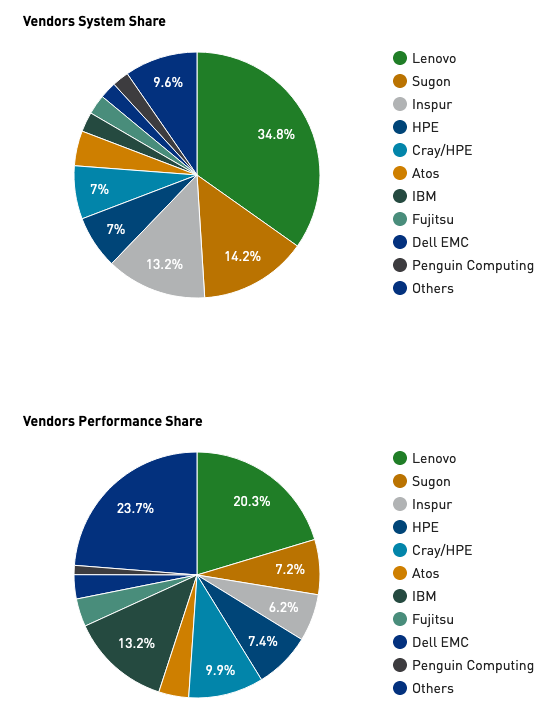

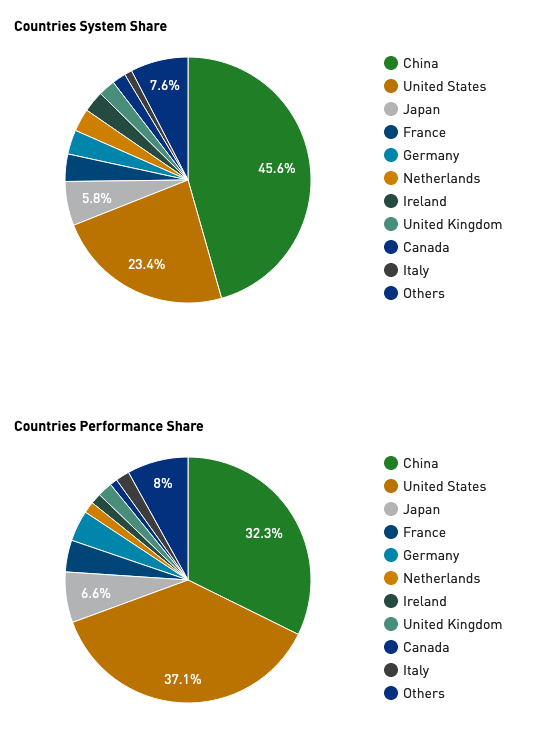

第54届全球超级计算机TOP500强前十名与53届相同,但是新的500强的总体性能不断提高,其中中国超算数量占比45.6%。

2018年11月18日,最新一期(第54届)全球超级计算机TOP500公布,中国和美国依然保持了统治地位,其中中国超算在数量上领先,占45.6%,美国超算则在平均性能上占有优势。

目前上榜的中国超算有227个,而六个月前为219个。同时,美国系统的份额仍接近历史最低点118。但是,美国系统的份额平均要大得多,占该列表总性能的37.8%。中国以31.9%的表现份额紧随其后。但是,与六个月前相比,这种性能差距有所缩小。2019年6月的榜单上,美国占榜单总表现的38.4%,中国占29.9%。

日本在TOP500系统中排名第三,为29,其次是法国(18),德国(16),荷兰(15),爱尔兰(14)和英国(11)。所有其他国家均以个位数表示。

新的500强的总体性能不断提高,目前为1.66 exaflops。上榜的门槛也从2019年6月的的1.02 petaflops增加到1.14 petaflops。

数据来源:top500.org

数据来源:top500.org

2019年54届TOP500超算榜前十名

|

Rank |

Name |

Country |

|

1 |

Summit |

United States |

|

2 |

Sierra |

United States |

|

3 |

Sunway TaihuLight |

China |

|

4 |

Tianhe-2A |

China |

|

5 |

Frontera |

United States |

|

6 |

Piz Daint |

Switzerland |

|

7 |

Trinity |

United States |

|

8 |

AI Bridging Cloud Infrastructure (ABCI) |

Japan |

|

9 |

SuperMUC-NG |

Germany |

|

10 |

Lassen |

United States |

排名前十的系统与6月的榜单相同,美国的Summit和Sierra仍位居前两名。两者都是IBM制造的采用Power9 CPU和NVIDIA Tesla V100 GPU的超级计算机。橡树岭国家实验室的Summit系统以148.6 petaflops的HPL结果获得了冠军宝座。劳伦斯·利弗莫尔国家实验室(Lawrence Livermore National Laboratory)的Sierra系统为94.6 petaflops,排名第二。

第三名仍然是中国的神威.太湖之光Sunway TaihuLight超级计算机,其HPL标记为93.0 petaflops。太湖之光由中国国家并行计算机工程与技术研究中心(NRCPC)开发,并安装在无锡国家超级计算中心,配置的是国产的Sunway SW26010处理器。

神威.太湖之光

天河2A(银河2号)是由中国国防科技大学(NUDT)开发并部署在中国广州国家超级计算机中心的系统,以61.4 petaflops位居第四,由Intel Xeon CPU和Matrix-2000加速器提供动力。

Frontera是Dell C6420系统,其排名保持第五,HPL结果为23.5 petaflops。由Xeon Platinum处理器组成,于2018年安装在德克萨斯大学的德克萨斯高级计算中心。

排名第六的是Piz Daint,这是一台Cray XC50超级计算机,安装在瑞士卢加诺的瑞士国家超级计算中心(CSCS)中。它的容量为21.2 petaflops,这仍然是欧洲功能最强大的超算系统。

由Los Alamos国家实验室和Sandia国家实验室操作的Cray XC40系统Trinity以70.2 petaflops的HPL性能排名第七。它由Intel Xeon和Xeon Phi处理器提供动力。

排在第八位的是日本的AI Bridging Cloud Infrastructure(ABCI),安装在日本国立先进工业科学技术研究院(AIST)。富士通构建的系统配备了Intel Xeon Gold处理器和NVIDIA Tesla V100 GPU,HPL结果达到了19.9 petaflops。

来自德国的SuperMUC-NG以19.5 petaflops排名第九,该系统由联想搭建,配置Intel Platinum Xeon处理器提供动力。

Lassen超级计算机排名第10,提供了18.2 petaflops,采用IBM Power9 / NVIDIA V100 GPU架构。

TOP500列表中功能最强大的新型超级计算机是AiMOS,它显示在第25位,HPL结果为8.0 petaflops。IBM构建的系统安装在Rensselaer理工学院计算创新中心(CCI)上,与Summit,Sierra和Lassen一样,它配备了Power9 CPU和NVIDIA V100 GPU处理器。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。