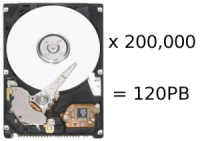

IBM打造20万个硬盘构成120PB容量的存储设备,预计可容纳约1万亿的文件或240亿首单曲容量5MB的MP3文件。

IBM位于加利福尼亚州Almaden的研究实验室正在进行一个新的项目:设计一个120PB容量的大型存储设备,我们今天的任何一个数据资料库与之相比都要相形见绌。这一新的存储设备将由20万块硬盘驱动器组成,预计可容纳约1万亿的文件或240亿首单曲容量5MB的MP3文件。IBM采用了自行研发的Neurosynaptic芯片完成了这一艰巨的任务,终于建立起这么一台非常令人印象深刻的机器。

更具体地说,Almaden实验室的工程师设计了新的硬件和软件技术,来将20万块硬盘放进水平推拉的抽屉,然后放置到机架进行安装。为了能够给硬盘降温,IBM将抽屉设计的比我们平常见到的更宽以尽可能多的放进硬盘,并将配满硬盘的抽屉塞进一个液态循环水冷的垂直机架中。在软件方面,IBM精心设计了他们的磁盘奇偶校验和镜像算法,比如说,当某块硬盘发生故障时,整台计算机仍然可以以接近全速的效果进行工作。如果单块硬盘发生故障,系统会从其它硬盘读取备份数据并写入到替换后的硬盘中,这就使得这台超级计算机依然能够处理数据。算法会控制数据重建的速度,并能够处理多块硬盘同时损坏的情况。

除了物理层面的数据分布,IBM还使用了一个新的文件系统来保护阵列中的所有文件。通过我们已经熟知的通用并行文件系统(GPFS),这一系统会将文件条带化到多个磁盘上,以达到并发读取,增大I/O的目的。此外,文件系统使用了一个新的索引方法,使其能够保持跟踪数十亿份文件,而无需扫描每个内容。

IBM存储研究总监Bruce Hillsberg表示,他们的算法使存储系统中的数据能够做到“万年不朽”,同时还不会对性能造成影像。Hillsberg进一步认为,尽管这个120 PB的存储阵列上如今看起来有些“疯狂”,不过对于云计算来说,存储的作用正在愈发显得重要。他透露说,只是跟踪文件的名称,类型和属性就使用了约2 TB的存储。

这一阵列目前正在搭建一个即将对外发布的客户端,其有可能用于高性能计算(HPC)项目,来存储大量的建模和仿真数据。包括全球气候模型,地震图形,大型强子对撞机(LHC)以及分子数据和模拟等项目将会从逐步增长的存储空间中受益。

尽管受到设备发热、数据错误、排列密度以及存储介质等方面的限制,不过对于数据存储的研究仍然正在以惊人的速度向前发展。尽管这台由20万块硬盘组成的120PB容量的阵列除了国家财政或财富500强企业以外没有人能买得起,不过这一技术本身绝对是有趣的,同时其在技术方面的成就也会眷顾到消费级产品中。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。