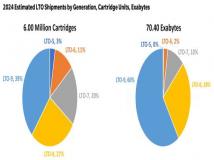

以成像为主的行业正在经历数据的爆炸式增长,而这会影响到他们存储系统支持工作流和生产流程的能力。这种数据的增长是呈现指数级的,而不是IT中常见的百分比增长。数据的大幅

以成像为主的行业正在经历数据的爆炸式增长,而这会影响到他们存储系统支持工作流和生产流程的能力。这种数据的增长是呈现指数级的,而不是IT中常见的百分比增长。数据的大幅度增长,再加上新的访问和远程协同使用实例,这些导致了现有数据系统在这些行业中陷入困境。我们需要一种新的方法来应对这些拥有大型数据集和图像应用的使用实例。对于这些共享大型图像数据集的行业来说,利用基于存储架构的云技术将可能成为一项必备要求。

那些将图像作为自己产品(媒体、医疗、绘图、遥感、石油和天然气)的行业正在推动着在高清电视和3D电影等图像质量方面的发展,DPI图像分辨率每翻一番就意味着文件大小增加4倍,这导致图像文件越来越大,从而给支持这些行业工作流程的数据系统带来巨大压力。以前,解决这个数据增长难题要求将终端用户固定在本地,或者使用低效率的文件共享流程。这个传统方法在上述的使用实例中正变得越来越低效,从而引发了对LAN环境外的文件分布和同步的需求。

医疗影像

从十年前就出现了数字医疗影像和数字化医疗记录转变的趋势。现在,医疗系统中的大多数数据卷都是和图像有关的,例如包含这些图像的患者信息等。大多数医疗成像设备都有追踪这种信息并保持与相关图像连接的数据库。医疗程序和工作流程现在要求能够从多个地点访问这些病人记录,而不仅仅是从一间医务室或者医院。

以前那些专有的成像设备现在支持一种被称为Dicom的标准,以便于远程文件共享和提供浏览病人记录的方法。当医生确定了他们需要查看的病人记录,那么系统必须传送整个图像文件。

数字媒体

与医疗成像行业的发展类似,数码相机、HDTV、HD和3D电影等也开始生成现有基础架构无法提供支持的大型数据集。一步高清电影中的每个帧都是普通帧大小的5~10倍。当用户在同一个LAN的时候,这就成了一个难题。数字媒体生产工作流每天都会涉及到向同一个目标的输入以及由全球各地技术人员以及艺术家们产生的数据集。这种非线性的文件增长导致由这些共享文件组成的中央存储效率降低,因为传输这些文件比提供这些文件要求更高的带宽。

遥感

那些生成和使用卫星和航空图像的行业也遇到了一些问题。每一代成像卫星都携带有分辨率更高(有时候甚至是数量级)的相机,结果产生了更大的文件。而且,以前那些静态图像现在变成了视频的形式,例如空中侦察等。结果导致数据呈指数级增长,并提出了能够从遍布全球各地被多方查看的需求。在支持这些广泛分布的大型数据集来说,集中的图像归档已经变得不切实际了。

石油和天然气

地质图像产生了庞大的数据集,同时意味着在收集和处理上也要有更高的投资。这些参考用数据集的大小通常在PB级,根据市场条件的要求,这些数据必须被妥善保存并确保远程位置的多个终端用户可以获取以便找回。传统文件传输方法效率很低,用户通常要求助于运输磁带或者USB硬盘驱动器。

这些实例的一个共同主题就是,我们不能避免将文件迁移到更加接近这些文件的终端用户那里的需求。现在和可预见的未来内的带宽问题,使得实时传输不适宜于支持任何有效的协同或者远程文件访问。这些数据集必须保存在更加接近终端用户的位置。

这种解决方案要求在地理位置上分散的用户中智能地保存文件,以保证副本更接近终端用户。拿集群NAS系统举例来说,它采用了一种以目标为主导的架构,使用分布式文件系统网关来对在不同地理位置的现有存储资源实施虚拟化。这种方法可以利用正在使用中的现有资产,作为本地的“孤岛”存储并重新利用这些存储来解决成本。

这种架构将数据作为目标、文件或者文件组(还包括相关的元数据)来生成和保存,这样就可以广泛分布数据,无需从一个集中的“主”位置进行直接控制就可以进行拷贝。结果就形成了一个可以将数据透明地复制到多个位置的分布式存储系统。这个解决方案可以帮助上面我们所说的那种以成像为主、支持远程文件访问、从一个集中位置与大型数据集相协同的行业解决难题。这些系统还可以利用“存储和转发”技术来让用户在所有块被发送到目的地之前打开一个文件。

数据完整性

大型的参考数据归档需要提供数据保护功能以及确保数据的长期完整性。提供数据保护就要求在用户站点保存多个副本。每个数据目标都有一个特殊的标识符,它是元数据架构的组成部分,可以在存储和找回操作中用于完整性检查。当一个目标未通过检查,那么就从另一个位置提取相同目标,拷贝以取代它。通过这种方式,系统可以“自我治愈”并未长期存储提供了另一重保障。

图像文件大小的快速增加,在地理位置分散的用户之间共享图像,这两个发展趋势将推动着众多行业保存和管理生产数据的方式的转变。医疗成像、数字媒体制作、遥感以及相关行业正面临着现有方法不容易支持的文件共享要求。新的以目标为导向的云存储解决方案可能就是答案。通过智能地将数据副本保存在更加接近用户位置的地方(而不是保存在中央存储库),他们可以满足这两个发展趋势引发的文件迁移挑战,并为那些以成像为主的行业的未来发展提供支持。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。