1 概述

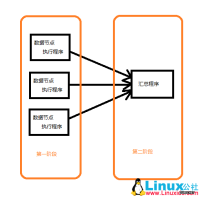

Zookeeper分布式服务框架是 Apache Hadoop 的一个子项目,它主要是用来解决分布式应用中经常遇到的一些数据管理问题,如:统一命名服务、状态同步服务、集群管理、分布式应用配置项的管理等。 ZooKeeper本身可以以Standalone模式安装运行,不过它的长处在于通过分布式ZooKeeper集群(一个Leader,多个 Follower),基于一定的策略来保证ZooKeeper集群的稳定性和可用性,从而实现分布式应用的可靠性。Zookeeper 会维护一个具有层次关系的数据结构,它非常类似于一个标准的文件系统,如下图所示

Zookeeper 这种数据结构有如下这些特点:

每个子目录项如 NameService 都被称作为 znode,这个 znode 是被它所在的路径唯一标识,如 Server1 这个 znode 的标识为 /NameService/Server1

znode 可以有子节点目录,并且每个 znode 可以存储数据,注意 EPHEMERAL 类型的目录节点不能有子节点目录

znode 是有版本的,每个 znode 中存储的数据可以有多个版本,也就是一个访问路径中可以存储多份数据

znode 可以是临时节点,一旦创建这个 znode 的客户端与服务器失去联系,这个 znode 也将自动删除,Zookeeper 的客户端和服务器通信采用长连接方式,每个客户端和服务器通过心跳来保持连接,这个连接状态称为 session,如果 znode 是临时节点,这个 session 失效,znode 也就删除了

znode 的目录名可以自动编号,如 App1 已经存在,再创建的话,将会自动命名为 App2

znode 可以被监控,包括这个目录节点中存储的数据的修改,子节点目录的变化等,一旦变化可以通知设置监控的客户端,这个是 Zookeeper 的核心特性,Zookeeper 的很多功能都是基于这个特性实现的,后面在典型的应用场景中会有实例介绍

2 环境部署

此次Zookeeper集群的部署基于前一篇文章所部署的Hadoop集群,集群配置如下:

zookeeper1 rango 192.168.56.1

zookeeper2 vm2 192.168.56.102

zookeeper3 vm3 192.168.56.103

zookeeper4 vm4 192.168.56.104

zookeeper5 vm1 192.168.56.101

3 安装和配置

3.1 下载安装Zookeeper

从Apache官网下载最新的Zookeeper版本,解压到/usr目录,并重命名为zookeeper:

tar zxvf zookeeper-3.4.5.tar.gz ;mv zookeeper-3.4.5 /usr/zookeeper

设置zookeeper目录的所有者为hadoop:hadoop:

chown -R hadoop:hadoop /usr/zookeeper

ps:可先在master机器上进行安装和配置,然后通过scp命令复制到集群其他节点上:

scp -R /usr/zookeeper 节点ip:/usr

3.2 配置Zookeeper

3.2.1 创建数据目录

在集群所有机器上执行:

mkdir /var/lib/zookeeper

3.2.2 配置环境变量

vim /etc/profile:

# set zookeeper path

export ZOOKEEPER_HOME=/usr/zookeeper

export PATH=$PATH:$ZOOKEEPER_HOME/bin

3.2.3 配置Zookeeper集群

cp /usr/zookeeper/conf/zoo_sample.cfg zoo.cfg

vim zoo.cfg:

# The number of milliseconds of each tick

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

syncLimit=5

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

dataDir=/var/lib/zookeeper

# the port at which the clients will connect

clientPort=2181

#

# Be sure to read the maintenance section of the

# administrator guide before turning on autopurge.

#

# http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

#

# The number of snapshots to retain in dataDir

#autopurge.snapRetainCount=3

# Purge task interval in hours

# Set to "0" to disable auto purge feature

#autopurge.purgeInterval=1

server.1=192.168.56.1:2888:3888

server.2=192.168.56.102:2888:3888

server.3=192.168.56.103:2888:3888

server.4=192.168.56.104:2888:3888

server.5=192.168.56.101:2888:3888

注解:

tickTime:发送心跳时间间隔,单位毫秒

initlimit 和sysncLimit:两者都是以ticktime的总数进行度量(上面的时间为10*2000=20s)。initLimit参数设定了允许所有跟随者与领导者进行连接并同步的时间,如果在设定的时间内内,半数以上的跟随者未能完成同步,领导者便会宣布放弃领导地位,然后进行另外一次领导 者选举。如果这种情况经常发生,通过查看日志中的记录发现,则表明设定的值太小。

syscLimit参数设定了允许一个跟随者与领导者进行同步的时间。如果在设定的时间内,一个跟随者未能完成同步,它将会自己重启,所有关联到这个跟随者的客户端将连接到另外一个跟随者。

dataDir:保存的zookeeperk中持久化的数据,zk中存在两种数据,一种用完即消失,一种需要持久存在,zk的日志也保存在这。

server.A=B:C:D:其中 A 是一个数字,表示这个是第几号服务器;B 是这个服务器的 ip 地址;C 表示的是这个服务器与集群中的 Leader 服务器交换信息的端口;D 表示的是万一集群中的 Leader 服务器挂了,需要一个端口来重新进行选举,选出一个新的 Leader,而这个端口就是用来执行选举时服务器相互通信的端口。如果是伪集群的配置方式,由于 B 都是一样,所以不同的 Zookeeper 实例通信端口号不能一样,所以要给它们分配不同的端口号。

在每个服务器的数据目录中创建myid文件,文件的内容为以上对应的server.id中的id:

echo id >> /var/lib/zookeeper/myid

3.3 启动和停止Zookeeper服务

在集群所有节点上启动Zookeeper:zkServer.sh start

[root@rango ~]# zkServer.sh start

JMX enabled by default

Using config: /usr/zookeeper/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

查看:zkserver.sh starus:

[root@rango ~]# zkServer.sh status

JMX enabled by default

Using config: /usr/zookeeper/bin/../conf/zoo.cfg

Mode: follower

ps:启动之前需关闭iptables(内网)

ZooKeeper 的详细介绍:请点这里

ZooKeeper 的下载地址:请点这里

在zookeeper中实现了一个类似file system系统的数据结构,比如/zookeeper/status。 每个节点都对应于一个znode节点。

zookeeper的安装基本上可以按照官网,这里主要介绍下zookeeper安装部署一个集群的步骤。

Zookeeper是hadoop的一个子项目,本文简单分析zookeeper的工作原理,对于如何使用zookeeper不是本文讨论的重点。

HBase是Google Bigtable的开源实现,HBase利用Hadoop HDFS作为其文件存储系统;HBase同样利用Hadoop MapReduce来处理HBase中的海量数据,HBase利用Zookeeper作为对应。

Zookeeper基本原理,通常Zookeeper由2n+1台servers组成,每个server都知道彼此的存在。每个server都维护的内存状态镜像以及持久化存储的事务日志和快照。对于2n+1台server,只要有n+1台(大多数)server可用,整个系统保持可用。

【聚焦搜索,数智采购】2021第一届百度爱采购数智大会即将于5月28日在上海盛大开启!

本次大会上,紫晶存储董事、总经理钟国裕作为公司代表,与中国—东盟信息港签署合作协议

XEUS统一存储已成功承载宣武医院PACS系统近5年的历史数据迁移,为支持各业务科室蓬勃扩张的数据增量和访问、调用乃至分析需求奠定了坚实基础。

大兆科技全方面展示大兆科技在医疗信息化建设中数据存储系统方面取得的成就。

双方相信,通过本次合作,能够使双方进一步提升技术实力、提升产品品质及服务质量,为客户创造更大价值。