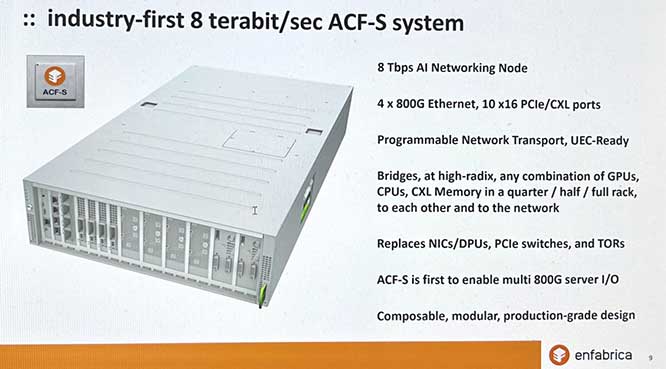

Enfabrica正在开发一个8Tbps交换平台,能够将GPU、CPU、CXL连接的DDR5内存和SSD存储的任意组合直接连接到高性能的多端口800千兆以太网网络。

初创公司Enfabrica正在开发一种加速计算结构交换芯片,以组合和桥接PCIe / CXL和以太网结构,已经筹集了1.25亿美元的B轮融资。

其融合了内存和网络结构架构的技术旨在为 GPU 带来比当前使用 CXL 式池化的 HBM 技术更多的内存,并通过基于多 TB 以太网的交换方案将数据馈送到内存中。这依赖于正在开发的ACF-S芯片和100-800Gbps以太网链路。

首席执行官兼联合创始人Rochan Sankar表示:“当今人工智能热潮的根本挑战是基础设施的规模......大部分扩展问题在于连接到GPU计算的I / O子系统,内存移动和网络,Enfabrica的ACF解决方案在这方面大放异彩。

本轮融资由Atreides Management领投,现有投资者Sutter Hill Ventures,Valor,IAG Capital Partners,Alumni Ventures和Nvidia作为战略投资者参与。Enfabrica的估值比2022年的5000万美元A轮估值上涨了5倍。

Enfabrica正在开发一个8Tbps交换平台,能够将GPU、CPU、CXL连接的DDR5内存和SSD存储的任意组合直接连接到高性能的多端口800千兆以太网网络。它拥有大约 100 名工程师,负责构建芯片和软件,分别位于加利福尼亚州山景城、北卡罗来纳州达勒姆和印度海得拉巴。

它根据层查看内存。DDR 和 HBM 以个位数的 TB 容量形成最快的层。第 2 层是 ACF-S 设备本地的 CXL 内存,容量达数十 TB。RDMA 发送/接收访问的网络内存是第 3 层,具有数千 TB 的容量。可以根据需要为特定工作负载组合 ACF-S 连接的内存。

该公司已经证明其交换机芯片架构和设计是正确的,应该会按预期加速向GPU的数据传输。到目前为止,风险投资公司已经对其进展深信不疑,现在它有资金来建造它。Sankar说:“我们的B轮融资和投资者是对我们的团队和产品论点的认可,并进一步使我们能够生产高性能ACF芯片和软件,从而提高AI计算资源的有效利用和扩展。

Enfabrica认为其技术特别适合AI/ML推理工作负载,这与AI/ML训练不同。Sankar说,目前的训练系统将更多的GPU组合在一起,而不是仅仅为了获得足够的内存而计算所需的GPU。根据Sankar的说法,这意味着GPU没有得到充分利用,其昂贵的处理能力被浪费了。

ACF-S芯片和相关软件应使客户能够在同一性能点上将LLM推理的GPU计算成本降低约50%,将深度学习推荐模型推理的成本降低75%。这是在互连设备节省的基础上,因为Enfabrica方案取代了NIC,SerDes,DPU和架顶式交换机。

采用Enfabrica的ACF-S芯片的ACF交换系统将具有100%符合标准的接口和Enfabrica的主机网络软件堆栈,这些软件堆栈在标准Linux内核和用户空间接口上运行。

Sankar证实,Enfabrica技术将与高性能计算相关,进入该市场几乎不需要开发。从理论上讲,Enfabrica可以支持InfiniBand和以太网,但认为没有必要这样做。

客户可以通过联系Enfabrica预订系统.

引导说明

SerDes是一种串行器解串器集成电路设备,可互连单线并行和串行网络链路。串行器或发送器将并行数据转换为串行流,而解串器或接收器将串行数据转换为并行流。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。